AIの時代に、残る音楽。演奏家によるライブと、人体センシング。 ~ 絵と詩と音楽 (n) ~

前回は、学生時代の音楽活動とその背景について書いた。

今回は、それ以降のできごと、「センサー×音楽」を考え始めた経緯と現状について。

動作の回数を数値化。データ形式変換によるコンテンツを提唱。

この社会は煩雑だ。創造性には無関係なもので溢れている。作るために作られる制度。ヒトを破壊するために作られる製品。遠くを眺めていても、足をつかんで近くに引き戻される。だから、なかば諦めてノリで生きている。

最初の勤務先は、1年で退職した。きっかけは、父の医療費の請求額に腰を抜かしたことだ。ハローワークで、高給の技術職を見つけ、転職。AV機器の技術仕様書を編集し、取扱説明書のイラストを描いた。オーディオとビデオのしくみを知るために、職場の図書室にあった、日経エレクトロニクスやラジオ技術などの雑誌を読んだ。

1985年、入社1年目のある日、勤務先の役員が声をかけてきた。技術系企業の役員たちが、パソコンのサークルを作り、定期的に勉強会を開いている。数カ月後、技術イベントが開催される。そのサークルで参加することになった。設計・製造・制御技術はある。メンバー所有のパソコンは集めれば十数台。それを活用して、来場者が楽しみながら技術に触れられる出展物を製作したい。企画を頼む。

その頃、「美術手帖」を定期購読していた。ナム・ジュン・パイクやヨーゼフ・ボイスを取り上げた記事を、興味深く読んでいた。

パソコンを使ったインスタレーションはどうだろう?と考えた。

AV機器では、磁気の情報を映像や音の情報に変換して出力している。データ形式の変換による出力。ヒトの動作を、目に見えるかたちにできないか。

複数の企画案を提出した。そのうちのひとつを、依頼してきた役員が実装可能な機能に絞り込んだ。説明を受け、筆者がラフスケッチに落とし込む。その1枚をもとに、パソコンサークルのメンバー企業が、得意とする技術で分担して、設計、製造。

音楽に合わせて、ステージの足元に仕込んだLEDが点滅する。ステップがその場所にヒットすればカウント。パソコンに集計結果をリアルタイムでグラフ表示。

翌年、イベント開催。会場の一角は大賑わいとなった。来場者は自由に参加して、踊りながらステップを踏んだ。この装置は人気を博し、イベント終了後、百貨店から引き合いがあったという。しかし、数日間のイベント用に制作したものであり、それ以上の耐久性は保証できないことから、引き渡しを見合わせたと聞いた。

ラフスケッチは、手持ちの筆ペンでコピー用紙にザッと描いたものなのでリンクはしないが、装置の写真とともに、ウェブ上で公開されている。懐かしい、というよりも、つい先日のことのような気がする。

ふたつの作曲方法。イメージの出力。イメージの創造。

動作を視覚化。データ変換によるコンテンツ。そのテーマが頭の中で膨らみ、次に考えたのが、脳波による作曲だった。

1980年代半ば、まだ脳波センサーは夜明け前。というよりも、センサーと呼べるほどのものはなく、2~3の大学で研究が始まったばかりだった。当然、実用化どころか試作さえ考える段階にはない。

その状況で、作曲への利用を考えた背景には、筆者の作曲方法がベースにある。

それは、「頭の中に流れてくる完成した曲を、譜面に記録する」というものだ。演奏よりも作曲編曲が先立つのは、筆者がプロの演奏家ではないからだろう、

採譜という作業は、正直なところ、手間で、面倒だ。そのうえ、譜面に起こしたところで、演奏しなければ音楽のかたちにはならない。

だから、頭の中に流れる音楽を、ダイレクトに取り出すことはできないか、と考えたのだ。脳波センサーを使って、脳内データを取得し、それを対応する音に変換して出力できないものか。

ただし、すべての作曲者が、このような作曲方法を採用しているわけではない。

先の方法は、作曲者が演奏を手掛けない、曲ありきの方法だろう。

もうひとつ、作曲者自身が演奏する、音ありきの方法がある。

楽器から出力できる音を紡ぎ、その音を織って曲を創る。織られた曲の中の、パーツとしての音の表現を問い直す。部分から全体へ、全体の中の部分へ、フィードバックを繰り返しながら、クオリティを高めていく。

たとえば、ロックバンド「TERROR SQUAD」の大関氏。「6弦のカナリア」の校正時に聞く限りでは、(すべての曲がそうではないかもしれないが)自身が弾くことを前提として、演奏した結果までイメージして、曲を練り上げている。大関氏は作曲家で編曲家だが、それ以前に、プロのギタリストだからだろう。

スコアやTAB譜には、ギタリストが繰り出す各ノートの詳細を記録できない。つまり、譜面は中間フォーマットとしての役割をじゅうぶんに果たすものではない。独自のピッキング・テクニックで音を生み出しているのだから、ほかのギタリストが再現することは不可能だ。

前者はウォーターフォール的、後者はアジャイル的、といえるかもしれない。

生体あってこそ、生み出しうる音楽。生き残る音楽。

脳内情報を扱うとなると、倫理的な問題を避けて通ることはできない。2010年から2014年まで、メールマガジン「日刊デジタルクリエイターズ」に、月1回書いていた「データ・デザインの地平」。第7回(2011年06月13日配信)では、「脳活動センシングの進化が作曲を変える」と題して、まずは、脳波作曲が実現した暁に起こりうる倫理的な問題を取り上げた。

80年代と違い、今では、脳波センサーは軽量で高精度化、試作に耐えうるものとなっている。そこで、脳波作曲のアウトラインを、技術コラムとして書いてみようと考えた。

ちょうど2012年から、Windows Phoneのセンサーアプリ開発について、インプレスのThinkITに連載記事を書いていた。Windows Phoneに搭載された4種類のセンサー(加速度、コンパス、ジャイロスコープ、複合モーション)を使ったアプリを開発するなかで、センサーが異なっても、センシングデータの取得処理は、大きくは違わないことがわかった。脳波センシングも考えていこう。それはいずれ、此岸と彼岸の境界において、社会にとって必要となるものだから。

担当編集者が音楽に明るい人だったことから、「脳波センサー×音楽」の短期連載を提案。企画が通過して、執筆に着手した。本文がラフに書けたところで、テストプログラムを添付したほうが、読者にとってわかりやすい記事になると考えた。

脳波センサーは標準搭載されていないので、別デバイスをPCや携帯端末に接続するかたちになる。

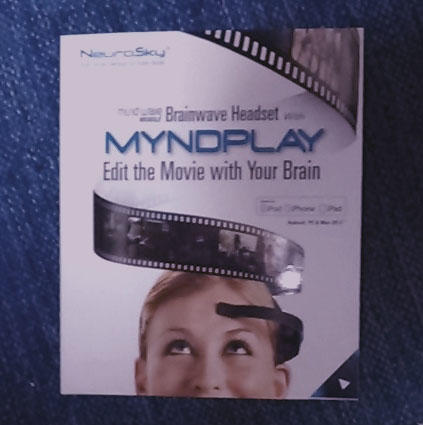

筆者が購入したのは、NeuroSky MindWave Mobile Myndplay Bundle (下写真)。

対応環境は、Windows Vista, Windows 7 (Intel Core Duo +-1GB RAM Direct X 9.0対応, 2GB HD空き容量)。

開発環境は、Visual Studio 2013 Update 3。 これで、Windows Phoneアプリのプロトタイピングを作り、ストアに公開―――という予定だったのだが、これが頓挫した。

Windows 7からWindows8へ変わりつつあった頃だ。筆者の環境では、Windows 8.1 でも動作自体は確認した。だが、Bluetooth接続が頻繁に切断されるという問題が発生。

この問題の解決に手間取るうち、Windows Phone自体が頓挫。筆者は家族の健康管理に専念せざるをえない状況となり、さらに介護が始まり、プログラミングを継続できない状況となっている。

Bluetoothの切断については、Microsoft MVPや元MVPの方々の技術力をお借りすれば、即座に解決した可能性がある。ああ、この人に聞けば知っているにちがいない、とおもいあたる人が数名いる。

しかし、筆者はそれを実行しなかった。企画や課題を公開すると、当然、コラボレーション・ユニットのメンバーが企画を知り、共同開発の流れができてしまう。それでは、筆者の知らぬ間に、企図とは異なる方向へ進んでしまうのだ。トランスサイエンスを必須とし、クオリティに言及する筆者と、効率を最優先して、売上のみ追求するメンバー。エンジニアリングに対する考え方の異なる者がコラボレーションすると、開発が進むにつれて、問題が噴出する。開発実務よりも、その問題解決にエネルギーを使い果たすことになる。

脳波センシングによる作曲は、何十年も頭の片隅にあったテーマだ。コラボレーションによる頓挫は避けたい。

現在は、介護のため、プロトタイピングをできる環境にはない。そこで、先に、技術コラムとして執筆する方向で考えている。

演奏家が作曲編曲まで手掛け、来場者とエネルギーを交換し合って、場を創り上げる、音楽。

脳内にある音楽を、技術の力で取り出して出力し、リスナーにダイレクトに伝達する、音楽。

両極に位置する音楽。だが、どちらも、人体、生身の身体があってこそ、生み出しうる音楽だ。

今後、計算機が創作活動を担うようになるとき、生体由来の音楽として、この2つは、確実に残る。

次回は、筆者がDTMに取り組み始めた理由と、その背景について。