クローラビリティとは? 検索エンジンのロボット向け最適化対策

クローラビリティとはクローラーという検索エンジンのWebページ収集用ロボット向けに最適化するための取り組みです。適切にクロールさせることで新規ページのインデックスを早めたり、既存ページの変更を検索エンジンが認識しやすくなります。大規模サイトにおいて新規ページのインデックスが遅いと感じる場合はクローラビリティを見直すことで改善できる場合があります。サイト運営においてクロール導線は大切です。今一度クローラビリティの点から導線設計をお考えください。

検索エンジンクローラーの仕組み

検索エンジンのクローラーはウェブページのURLリストにあるページにアクセスします。人間のようにウェブページを閲覧し、リンクをたどる訳ではありません。1ページ1ページ、リストにあるURLにアクセスするだけです。

- ウェブページのURLリストにあるページへアクセスする

- 新しいページを見つけた場合、ウェブページのURLリストに追加する

新しいページを見つける方法は次の2つです。

- 他のサイトやページからのリンクをたどる

- 送信されたサイトマップのリストから読み取る

リンクまたはサイトマップが起点となります。新規ページへのリンクが深い階層のページにしか存在しない場合、クローラーがアクセスするまでに日数を要する場合があります。その分検索結果に表示されるのが遅くなります。このクローラーの仕組みはGoogleが発表しているページに記載されておりますのでご覧ください。

▼Google 検索の仕組み

https://support.google.com/webmasters/answer/70897

検索エンジンロボットのクロール頻度が低下する理由

ちなみに検索エンジンのクロール数は一定ではありません。クローラーはウェブページのURLリストにあるページへアクセスするだけなので、一般的にはURLリストの数が多い大規模サイトの方が小規模サイトよりもクロール数は多いと言えます。しかし、様々な理由からクロール数が減少するケースもあります。

- robots.txtでブロックしている

- Webページが壊れている、サポートされていないメディアタイプである

- サーバーレスポンスが著しく遅い

- サーバーエラーが多発している

- サイトの更新頻度が低い、低品質なサイトと認識されている

上記情報はGoogleのウェブマスター向けヘルプページにて公開されています。Webサイトのクロール状況の把握は大切であることをご理解ください。

▼クロールの統計情報レポート(ウェブサイト)

https://support.google.com/webmasters/answer/35253

検索エンジンのクロール状況を把握するにはGoogle Search Consoleがおすすめです。Search Consoleは無料なので是非とともご活用ください。当ブログでもSearch Consoleはいずれ取り上げます。ちなみに弊社はクローラー解析ツールとGoogle Analyticsを連携させてクロール状況を把握しています。

▼Webの間のクローラー解析ツールはこちら

https://www.web-ma.co.jp/analytics/

クローラビリティを高める方法

さてここからはWebサイトのクローラビリティを高める方法を言及します。クローラビリティ対策としてまずは次の2点がポイントとなります。

- 内部リンクを見直す

- サイトマップを送信する

新規ページに対してどこのページからリンクされる設計となっているか? 新規ページに対してトップページからリンクされる設計の方がクロール導線が良く、少なくとも他のページのハブとなっているページからリンクされる構造が好ましいです。

また、新規ページをサイトマップへ追加する機能があると良いですね。サイトマップ作成のサービスはWeb上に多数ありますし、WordpressならXMLサイトマップ生成のプラグインもあります。こういうツールを活用するとクローラビリティが高まります。

ディレクトリ構造とURLについて

GoogleはURL構造をシンプルとすることを求めています。

▼シンプルな URL 構造を維持する

https://support.google.com/webmasters/answer/76329

シンプルなURL構造とはサイトの内容に即したディレクトリ構造とする、URLに意味を持たせる、ということです。以下はGoogleのページの引用ですが、パラメータだけではページの内容が判断しづらいです。URLは意味のある文字列で構成する方がクローラビリティが高まります。

航空機(aviation)に関する情報を探している場合、http://en.wikipedia.org/wiki/Aviation のような URL であれば、見ただけで必要な情報であるかどうかを判断できます。http://www.example.com/index.php?id_sezione=360&sid=3a5ebc944f41daa6f849f730f1 のような URL 自体は、ユーザーの関心を引くことはほとんどありません。

クローラー最適化へのさらなる取り組み

次にクロールページをコントロールする、クローラーの負荷を減らすという観点からの取り組みです。

- 重複ページを見直す

- 読み込み速度を向上させる

大規模サイトになるとどうしても重複ページが発生しやすくなります。特に一覧ページと言われる他ページをまとめたページは重複しやすいです。ECサイトで言うところの商品一覧ページをイメージするとわかりやすいです。商品一覧ページで内容が一緒でも「新着順」「安い順」「売れ行き順」といった並び替えページが存在している場合です。検索エンジンクローラーはこれら並び替えページをそれぞれクロールします。Webサイトのクロール数は無限ではないので、無駄なクロールを省くことで他のページがクロールされやすくなります。本件についてはこれだけで1ページ作れてしまうので細かいことは割愛します(いずれ改めてページを作ります)。詳しくは次のページをご覧ください。

▼重複した URL を統合する

https://support.google.com/webmasters/answer/139066

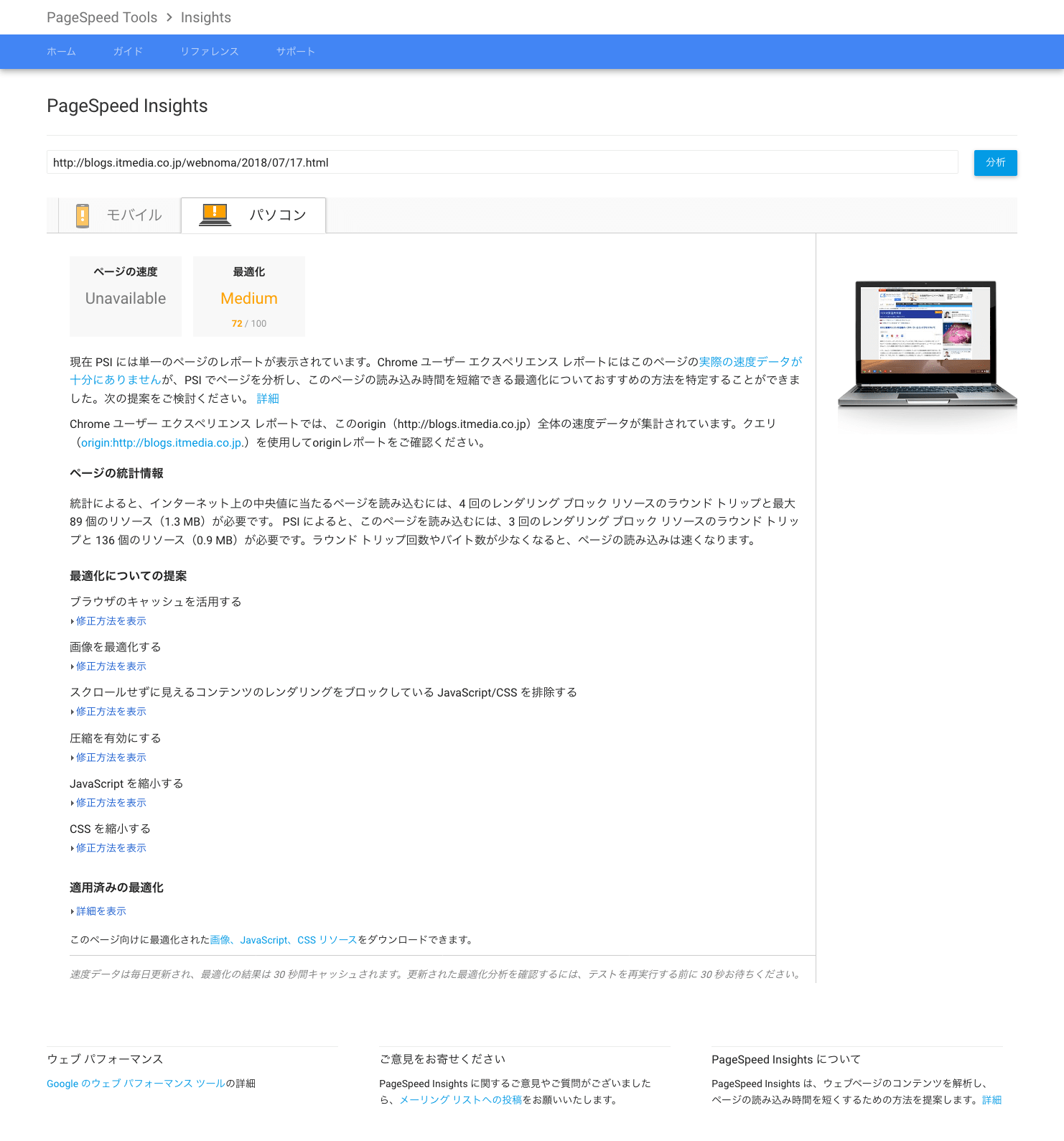

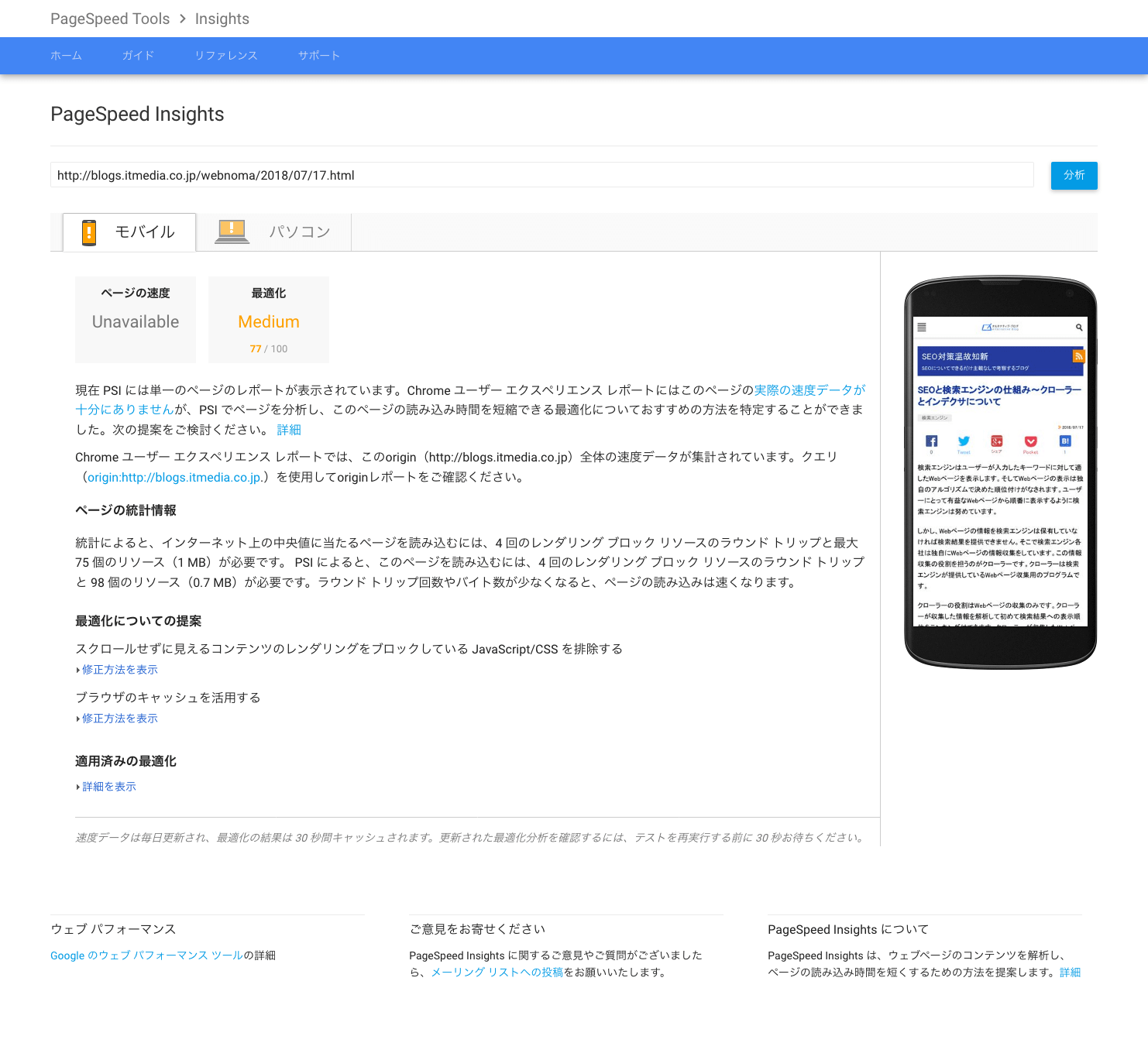

また、Webページの読み込み速度を向上させることでクロール負荷を減らすことに繋がります。GoogleはPageSpeed Insightsという読み込み速度判定ツールを用意しています。

▼PageSpeed Insights

https://developers.google.com/speed/pagespeed/insights/

例えば前回アップした記事に対するPageSpeed Insights結果はこちらです。

オルタナティブ・ブログのPageSpeed Insightsは惜しいですね。もう少し改善することでスコアを高くすることができます。読み込み速度の向上はクローラーだけでなく、ユーザーメリットもあるので是非ともお取り組みください。PageSpeed Insightsについても改めてページを作ります。

※当記事はWebの間のコラムを再編集したものです。元記事はこちら。

https://www.web-ma.co.jp/column/crawlability/84.html

https://www.web-ma.co.jp/column/crawlability/175.html