Google検索の音声認識がSiriよりすごい(気がする)理由

»

昨日、iOS版Google検索がアップデートされました。米国ではKnowledge Graphに対応するので、かなりのアップデートですが、日本では音声認識精度が上がったくらいなので(掲載できる記事本数に制限があることもあり)、記事にはしなかったのですが、この音声認識精度がかなりなものです。

こういうのは、テキストでは説明できないので、実際にやってみてもらうしかないのですが、かなり滑舌が悪い私が早口で「明日の天気を知りたいんだけど」などと言ってみても、ちゃんと理解してくれます。

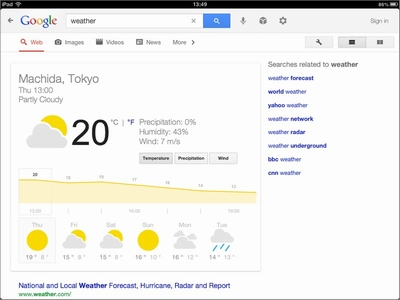

iPadの言語設定を英語にして「weather(うえざー、みたいなひどい発音で)」と言ってもちゃんと分かってくれて、町田市の天気をGoogle Now的に表示してくれます。 Siriは、私の英語をなかなか理解してくれないので、これは嬉しいです(weatherくらいならSiriも分かってくれるけど)。

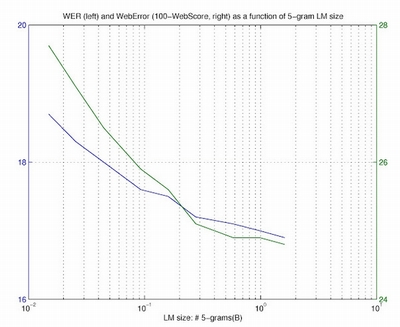

で、この違いはなんだろうと思っていたら、今日、Googleが自動音声認識についての難しそうな論文を発表しました。 確率の数式が出てきた時点でぱったり読むのをストップしたんですが、1つ分かったことは、GoogleはAppleが持っていないすごい財産を持ってるということ。 それは、Google検索の音声検索にユーザーが入力する音声データと、YouTubeなどのGoogleのサービスにアップロードされる動画の音声データです。これらのデータが匿名化されて、膨大なデータとして蓄積され、分析されているのです。 おぼろげにうっすらと読み取ったのは、N-gramモデルという、音声認識関連ではポピュラーらしい、「各単語の生起確率は、直前の(N-1)単語までのみに依存する」という考え方とこの膨大なデータを使うと、音声認識の精度が上がるらしいです。 例えば、Googleは音声検索データで、120億のN-gramから成る5-gramの言語モデルを作った(?)そうです。その結果、下のグラフのようにエラー率がぐぐっと下がった、と。どこがどうなってるのかすら私には分かりませんが、とにかく何かがぐっと減っていることだけは分かります。

こうした言語モデルの訓練のおかげで、音声認識精度の尺度であるワードエラー率が6~10%削減できたそうです。

難しいことはよく分かりませんが、実際にやってみると違いが分かるから、私にはそれで十分です。知的探究心のある方は実際の論文をどぞ。

SpecialPR